日前,第38届国际机器学习大会(International Conference on Machine Learning,ICML 2021)官方发布了论文录用结果。国家网络安全学院2018级研究生陈典撰写的论文以Long Presentation形式被录用。这是我院首篇在人工智能顶级会议ICML上录用的Long Presentation论文。

论文题目为“CARTL: Cooperative Adversarially-Robust Transfer Learning”(协同对抗鲁棒的迁移学习),指导老师为国家网络安全学院教授王骞(通讯作者),与纽约州立大学布法罗分校Hongxin Hu教授、香港城市大学王聪教授、西安交通大学沈超教授和清华大学李琦教授合作完成。

迁移学习作为机器学习领域的关键核心技术,能够有效地缓解训练模型时对训练数据规模和计算能力的需求。近年来,研究人员针对迁移学习进行了大量的研究,主要集中在提高迁移后模型在目标域上的准确率,而忽略了迁移后模型面对对抗样本攻击时的鲁棒性。该论文针对人工智能系统安全问题,分析了在迁移学习场景下,当深度神经网络面临对抗样本攻击时,迁移策略对神经网络鲁棒性的影响。

该论文弥补了现有分析的缺陷,在基于多种常用的图像数据集构建的迁移学习场景中,细致地探讨了在目标域上微调的模型层数对模型准确率及鲁棒性的影响,并揭示了两者之间存在的平衡问题,即随着模型微调的层数增加,其在目标域上的准确率与鲁棒性出现了不同步的变化。同时,该论文针对目前普遍采用的批归一化层,分析了其对于迁移学习后模型性能的影响,并通过大量实验证明:在迁移学习中有选择地重用批归一化层的参数,可以有效地提高系统的鲁棒性。

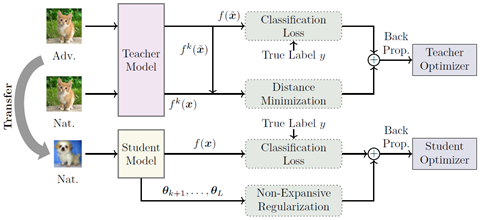

图1

进一步地,对于迁移学习过程中准确率与鲁棒性的平衡问题,该论文针对性地提出协同对抗鲁棒的迁移学习方案(如图1所示),分别针对源域模型的对抗训练阶段以及目标域模型的微调阶段设计了新算法:考虑源域模型中的部分网络层会被目标域模型重用——被用于提取输入的特征——对此该论文提出特征距离最小化,通过减少源域模型对正常样本与对抗样本所提取特征的差异程度,使其鲁棒性能够更加容易地被目标域模型继承;对于在目标域上的微调过程,该论文提出非拓展微调算法,通过限制微调部分的网络参数的利普希茨常数,降低模型对于对抗样本的敏感程度,从而使微调后的模型能够更好地从源域继承鲁棒性。作者在多个图像数据集(CIFAR、SVHN、GTSRB)上进行了大量实验和数据分析,实验结果充分验证了该方案的有效性。

据悉,本届ICML会议共收到有效投稿5513篇,共计1184篇被录用,其中Long Presentation录用仅166篇,录用率3%,被录用的稿件反映了人工智能安全国际最前沿的研究水平。